误导声称燃料炒作和患者安全风险,警告研究人员。

许多研究声称,人工智能与解释医学形象的人类专家一样好,质量差,可以夸张地夸张,造成了数百万患者警告研究人员的风险。

他们的调查结果提出了对基础上许多研究的证据质量的担忧,并突出了改善其设计和报告标准的必要性。

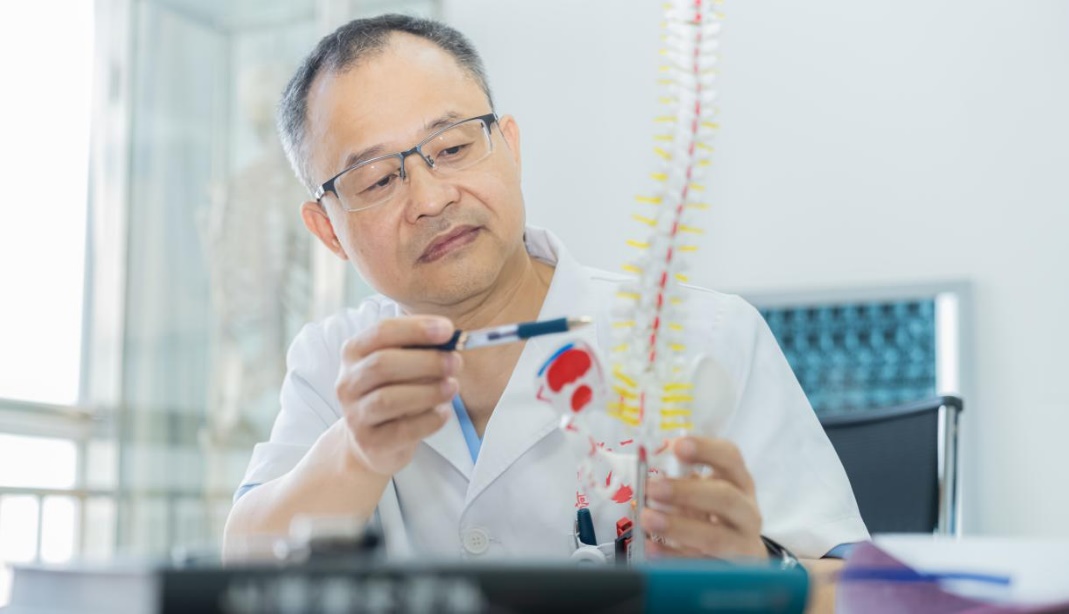

人工智能(AI)是一款创新和快速移动的领域,有可能改善患者护理,并减轻负担过重负担的保健服务。深度学习是AI的一个分支,它在医学成像中表现出特别的承诺。

关于深度学习的公布研究的数量正在增长,以及一些媒体头条新闻向医生索赔的卓越表现已经促使炒作迅速实施。但是,这些头条新闻背后的研究的方法和风险尚未详细审查。

为了解决这一问题,研究人员团队在过去10年中审查了已发表的研究结果,比较了与专家临床医生医学成像的深度学习算法的表现。

他们发现只有两个符合条件的随机临床试验和81项非随机研究。

在非随机研究中,只有九个是预期的(跟踪和收集有关杀戮的信息随着时间的推移),只有六个在“现实世界”的临床环境中进行了测试。

比较器集团的人类专家的平均数量只是四个,而获得原始数据和代码(以允许独立审查结果)严重限制。

判断超过三分之二(58个)的研究是偏见的高风险(可以影响结果的研究设计中的问题),并遵守认可的报告标准往往是穷人。

三个季度(61项研究)表示,AI的性能至少与临床医生的性能相当,只有31(38%)表示需要进一步的前瞻性研究或试验。

研究人员指出了一些局限性,例如错过研究的可能性以及对深度学习的重点进行了深入学习的医学成像研究,因此结果可能不适用于其他类型的AI。

然而,他们说,目前,“许多可夸张的夸张的声称存在于临床医生(或优越)临床医生,这在社会层面呈现患者安全和人口健康的潜在风险。”

过度夸张的语言“叶子研究易受媒体和公众误解的影响,因此可能提供不一定与患者最大利益的不恰当的护理,”他们警告说。

“通过确保我们开发高质量和透明报告的证据基础,最大限度地提供最大化患者安全性最大限度地提供服务。

参考:“人工智能与临床医生:由Myura Nagendran,Yang Chen,Christopher A Lovejoy,Anthony C Gordon,Matthieu Komorowski,Hugh Harvey,Eric J Topol,John Pa Ioannidis,Gary S Collins和Mahiben Maruthappu,2020年3月25日,BMJ.Doi:

10.1136 / bmj.m689